Construcción de canalizaciones fiables con Lakeflow Declarative Pipelines y Unity Catalog

En Barracuda, nuestro equipo de plataforma de datos empresariales se centra en ofrecer canalizaciones de datos fiables y de alta calidad que permitan a los analistas y líderes empresariales de toda la organización tomar decisiones informadas. Para impulsar esta iniciativa, hemos adoptado Databricks Lakeflow Declarative Pipelines (anteriormente DLT) y Unity Catalog para gestionar nuestros flujos de trabajo de extracción, transformación y carga (ETL), aplicar la calidad de los datos y garantizar una gobernanza sólida.

Lakeflow Declarative Pipelines nos ha permitido aprovechar nuestros datos de uso de clientes para aplicaciones que ayudan a los equipos de renovaciones y éxito del cliente a ofrecer mejores experiencias a los clientes. También hemos utilizado Lakeflow Declarative Pipelines y Unity Catalog para crear paneles de control para nuestros equipos ejecutivos, lo que les permite aprovechar los datos de varias fuentes para tomar decisiones financieras más informadas. Estos casos de uso dependen de datos altamente disponibles y precisos, para los cuales Lakeflow Declarative Pipelines ha proporcionado un soporte significativo.

¿Por qué Lakeflow Declarative Pipelines?

El marco de transformación declarativa principal de Databricks, representado en Lakeflow Declarative Pipelines, nos permite definir transformaciones de datos y restricciones de calidad. Esto reduce significativamente la sobrecarga operativa que supone la gestión de trabajos ETL complejos y mejora la observabilidad de nuestros flujos de datos. Ya no tenemos que escribir código imperativo para orquestar tareas; en su lugar, definimos lo que debe hacer la canalización y Lakeflow Declarative Pipelines se encarga del resto. Esto ha hecho que nuestras canalizaciones sean más fáciles de construir, entender y mantener.

De lotes a streaming

Lakeflow Declarative Pipelines proporciona funciones sólidas para optimizar el procesamiento de datos incrementales y mejorar la eficiencia en los flujos de trabajo de gestión de datos. Al utilizar herramientas como Auto Loader, que procesa de forma incremental los nuevos archivos de datos a medida que llegan al almacenamiento en la nube, nuestro equipo de datos puede manejar fácilmente los datos entrantes. La inferencia de esquemas y las sugerencias de esquema simplifican aún más el proceso al administrar la evolución del esquema y garantizar la compatibilidad con los conjuntos de datos entrantes.

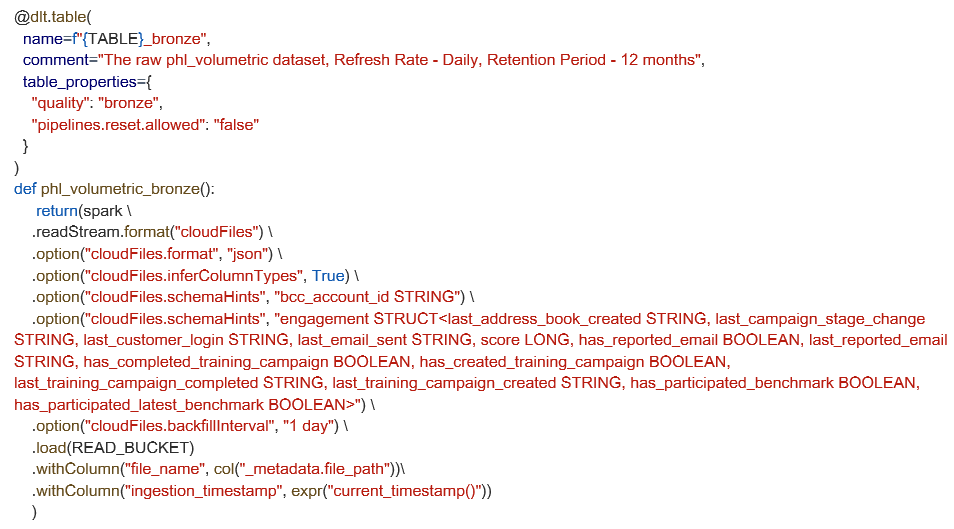

Aquí mostramos cómo definimos una tabla de ingesta de streaming usando Auto Loader. Este ejemplo muestra opciones de configuración avanzadas para sugerencias de esquema y ajustes de relleno, pero para muchas canalizaciones, la inferencia del esquema y los valores predeterminados integrados son suficientes para empezar rápidamente.

Otra característica poderosa que hemos adoptado es la compatibilidad de Lakeflow Declarative Pipelines con la captura automatizada de datos modificados (CDC) mediante la instrucción APLICAR CAMBIOS A. Para los datos almacenados en sistemas como S3, el procesamiento incremental se vuelve fluido. Este enfoque abstrae la complejidad de gestionar las inserciones, actualizaciones y eliminaciones. También garantiza que nuestras tablas descendentes permanezcan sincronizadas con los sistemas de origen mientras mantienen la precisión histórica cuando es necesario, especialmente cuando se trabaja con herramientas como Fivetran, que ofrecen transmisiones CDC. Estas capacidades garantizan que las canalizaciones de datos no solo sean precisas y fiables, sino también altamente adaptables a entornos de datos dinámicos.

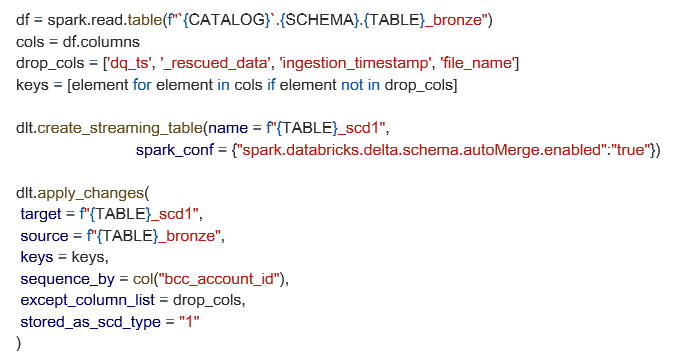

A continuación se muestra un ejemplo de una configuración de SCD1 más avanzada, usando nuestra tabla bronce como fuente, con combinación de esquemas y filtrado de columnas personalizado.

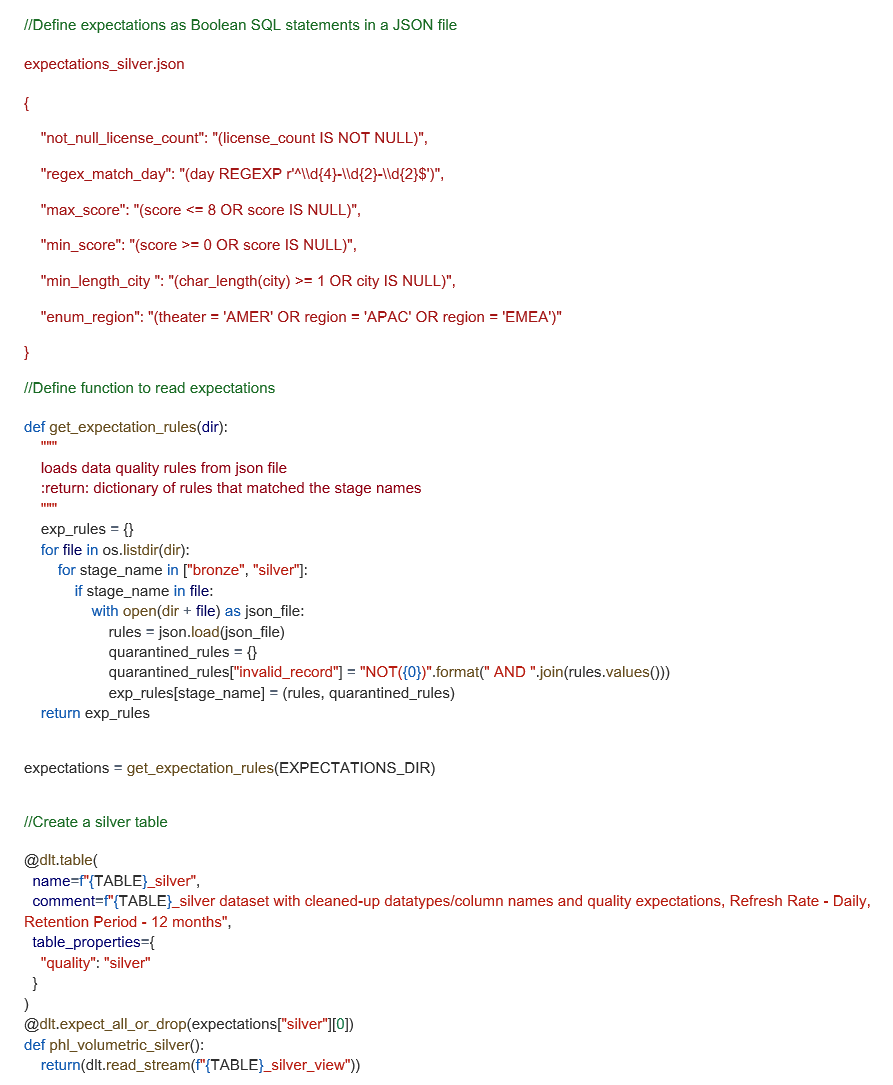

Hacer cumplir la calidad de los datos con expectativas

Las expectativas de Lakeflow Declarative Pipelines nos permiten probar la calidad de nuestros datos mediante la definición de restricciones declarativas que validan los datos a medida que fluyen a través de la canalización. Definimos estas expectativas como expresiones SQL booleanas y las aplicamos a cada conjunto de datos que ingerimos. Para optimizar la gestión de reglas, hemos creado un marco personalizado que carga las expectativas de archivos JSON, lo que facilita la reutilización de reglas en diferentes canalizaciones mientras se mantiene el código base limpio.

Esta es una implantación avanzada que funciona bien a nuestra escala, pero muchos equipos podrían comenzar con algunas declaraciones en línea y evolucionar con el tiempo. A continuación, mostramos cómo estructuramos las expectativas JSON y las aplicamos dinámicamente durante la ejecución de la canalización.

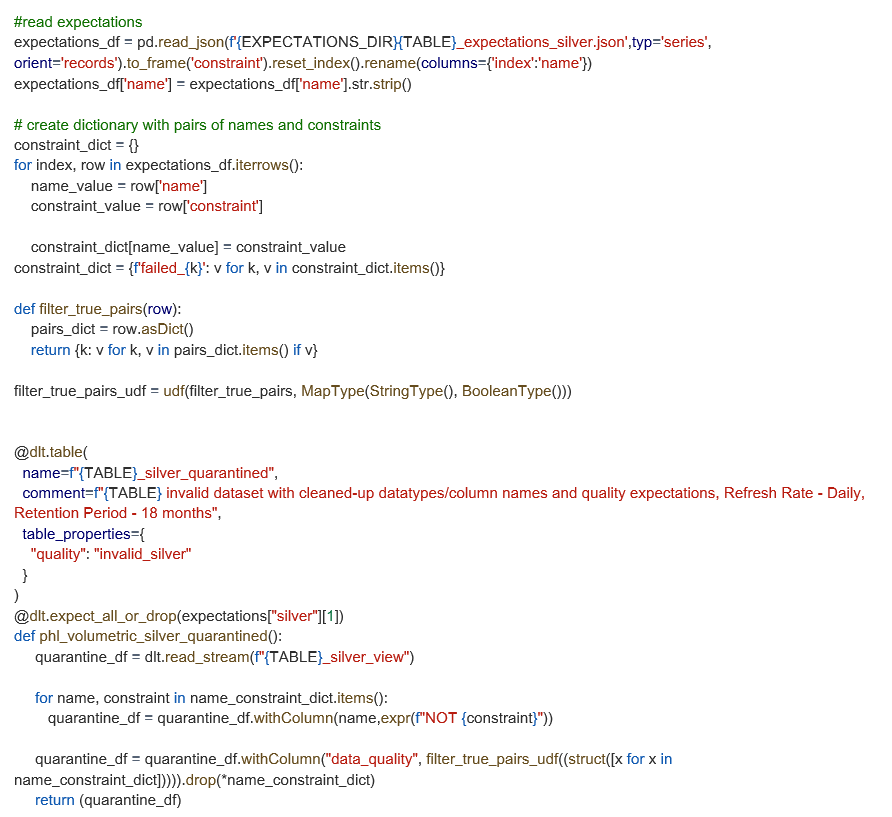

Mejorar las tablas de cuarentena con UDF

Si bien Lakeflow pone en cuarentena automáticamente los registros no válidos en función de las expectativas, ampliamos esta funcionalidad con una UDF personalizada para identificar qué reglas específicas violó cada registro. Este enfoque añade una columna «data_quality» a nuestras tablas en cuarentena, lo que facilita el seguimiento y la depuración de problemas de datos.

Esta personalización no es necesaria para los flujos de trabajo de cuarentena básicos, pero proporciona a nuestro equipo una visibilidad más clara de por qué fallan los registros y ayuda a priorizar la corrección de manera más eficiente. A continuación se muestra cómo implantamos esta mejora utilizando nuestras reglas de expectativas predefinidas.

Supervisión y gobernanza de la calidad de los datos con Lakeflow Declarative Pipelines + Unity Catalog

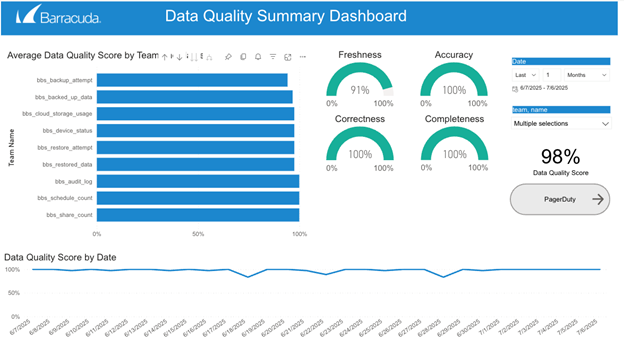

Lakeflow Declarative Pipelines captura automáticamente eventos de tiempo de ejecución detallados a través de su registro de eventos integrado, incluidas las validaciones de reglas, los registros en cuarentena y el comportamiento de ejecución de la canalización. Al consultar este registro, podemos generar métricas exhaustivas de calidad de los datos, supervisar el estado de más de 100 conjuntos de datos y detectar problemas de forma proactiva antes de que afecten a los usuarios finales.

Nos hemos basado en esta base configurando alertas en tiempo real que nos notifican el momento en que los datos no cumplen con las expectativas predefinidas o comienzan a desviarse de los patrones normales esperados. Estas alertas permiten a nuestro equipo investigar rápidamente las anomalías y tomar medidas correctoras.

Unity Catalog complementa esto con una gobernanza centralizada, un control de acceso granular y un linaje de datos completo. Este marco combinado mejora la confianza en nuestros datos, garantiza la aplicación coherente de las políticas de calidad y acceso y nos brinda una visibilidad clara del estado y la evolución de nuestros activos de datos.

Lecciones aprendidas y Best Practices

La implantación de Lakeflow Declarative Pipelines viene con restricciones únicas y características en evolución que mejoran la usabilidad del desarrollador y agilizan las operaciones. Al principio, las limitaciones, como el requisito de que solo se adjunten fuentes y un único objetivo por canalización, planteaban desafíos. Sin embargo, aprovechar funcionalidades como las sugerencias de esquema y la posibilidad de leer otras tablas dentro Lakeflow Declarative Pipelines mediante `spark.readTable` ha mejorado significativamente la flexibilidad. Además, nos hemos beneficiado enormemente de las características de calidad de datos de Lakeflow Declarative Pipeline. Hemos implantado más de 1000 restricciones de calidad de los datos en más de 100 tablas. También tenemos controles de calidad de datos en cada tabla de nuestro espacio de trabajo de Databricks. Esto facilita mucho el trabajo de nuestros analistas, ya que pueden encontrar, usar, comprender y confiar en los datos de nuestra plataforma.

Además de la calidad y la gobernanza de los datos, existen varios beneficios medibles para la empresa. El aprovechamiento de Lakeflow Declarative Pipelines ha permitido reducir notablemente el tiempo de desarrollo y acelerar la velocidad de entrega, además de minimizar los gastos generales de mantenimiento y aumentar la eficiencia del equipo. Por ejemplo, las canalizaciones construidas con Lakeflow Declarative Pipelines suelen requerir un 50 % menos de líneas de código que las que no son Lakeflow Declarative Pipelines, lo que agiliza tanto el desarrollo como el mantenimiento continuo. Esta eficiencia se ha traducido en tiempos de puesta en marcha más rápidos y en un apoyo más fiable a las necesidades empresariales en constante evolución. La fiabilidad de los datos también ha mejorado, lo que nos permite dar servicio a múltiples casos de uso posteriores, como nuestros First Value Dashboard y Customer Usage Analytics Dashboards, en diversos dominios empresariales.

La introducción del IDE de Lakeflow Pipelines, donde podemos generar transformaciones como archivos SQL y Python y acceder a la vista previa de datos, a las métricas de rendimiento de la canalización y al gráfico de la canalización (todo en una sola vista), ha aumentado aún más la velocidad de los desarrolladores. La migración de HMS a Unity Catalog refinó aún más este proceso al ofrecer una mejor visibilidad durante la ejecución de la canalización. A medida que Lakeflow Declarative Pipelines sigue madurando, adoptar estas buenas prácticas y lecciones aprendidas será esencial para maximizar tanto la calidad de los datos como la eficiencia operativa en nuestra plataforma.

Nota: Sanchitha Sunil y Grizel Lopez son coautores de esta publicación de blog.

Informe de Barracuda sobre Ransomware 2025

Principales conclusiones sobre la experiencia y el impacto del ransomware en las organizaciones de todo el mundo

Suscríbase al blog de Barracuda.

Regístrese para recibir Threat Spotlight, comentarios de la industria y más.

Seguridad de vulnerabilidades gestionada: corrección más rápida, menos riesgos, cumplimiento normativo más fácil

Descubra lo fácil que es encontrar las vulnerabilidades que los ciberdelincuentes quieren explotar.