Threat Spotlight: Lo bueno, lo malo y los "bots grises": los bots raspadores de IA de la generación que se dirigen a sus aplicaciones web

Los bots son programas de software automatizados diseñados para llevar a cabo actividades en línea a gran escala. Hay bots buenos, como el botsde rastreo de motores de búsqueda, el botsSEO y el bots de servicio al cliente, y botsmalos, diseñados para actividades en línea dañinas o maliciosas, como violar cuentas para robar datos personales o cometer Fraud.

En el espacio entre ellos se encuentra lo que BARRACUDA llama " botsgris". Los bots scraper de IA generativa son bots grises diseñados para extraer o raspar grandes volúmenes de datos de sitios web, a menudo para entrenar modelos de IA generativa. Otros ejemplos de bots grises son los bots raspadores web y los agregadores de contenido automatizados que recopilan contenido web como noticias, reseñas, ofertas de viajes, etc.

Los bots grises están difuminando los límites de la actividad legítima. No son abiertamente maliciosos, pero su enfoque puede ser cuestionable. Algunos son muy agresivos.

Recientemente informamos sobre cómo las organizaciones pueden proteger mejor su aplicación web, incluidos los sitios web, contra el raspado de Gen IA bots. En este informe analizamos lo que nos dicen los datos sobre la actividad de los bots grises de la Generación IA a la que se enfrentan las organizaciones hoy en día.

Los bots grises están hambrientos

Los datos de detección de BARRACUDA muestran que:

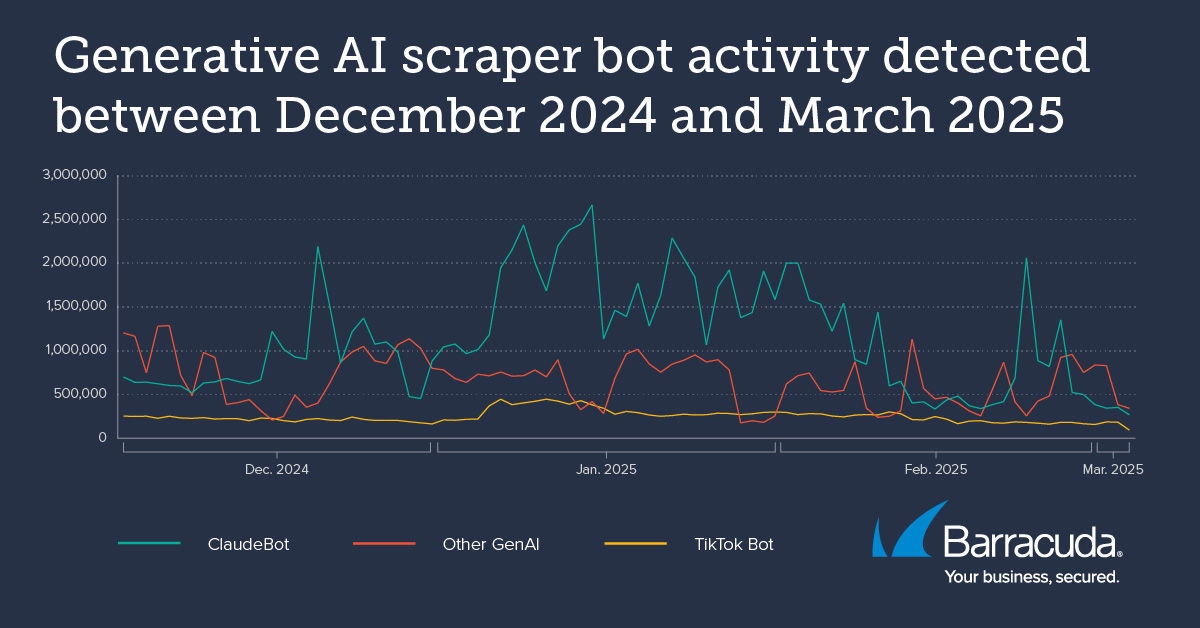

- Entre diciembre y finales de febrero de 2025, se recibieron millones de solicitudes por aplicación web de Gen IA bots, incluidos los bots ClaudeBot y Bytespider de TikTok

- Una aplicación web rastreada recibió 9,7 millones de solicitudes de bots scraper de la Generación IA durante un período de 30 días.

- Otra aplicación web rastreada recibió más de medio millón de solicitudes de bots scraper de la Generación IA en un solo día.

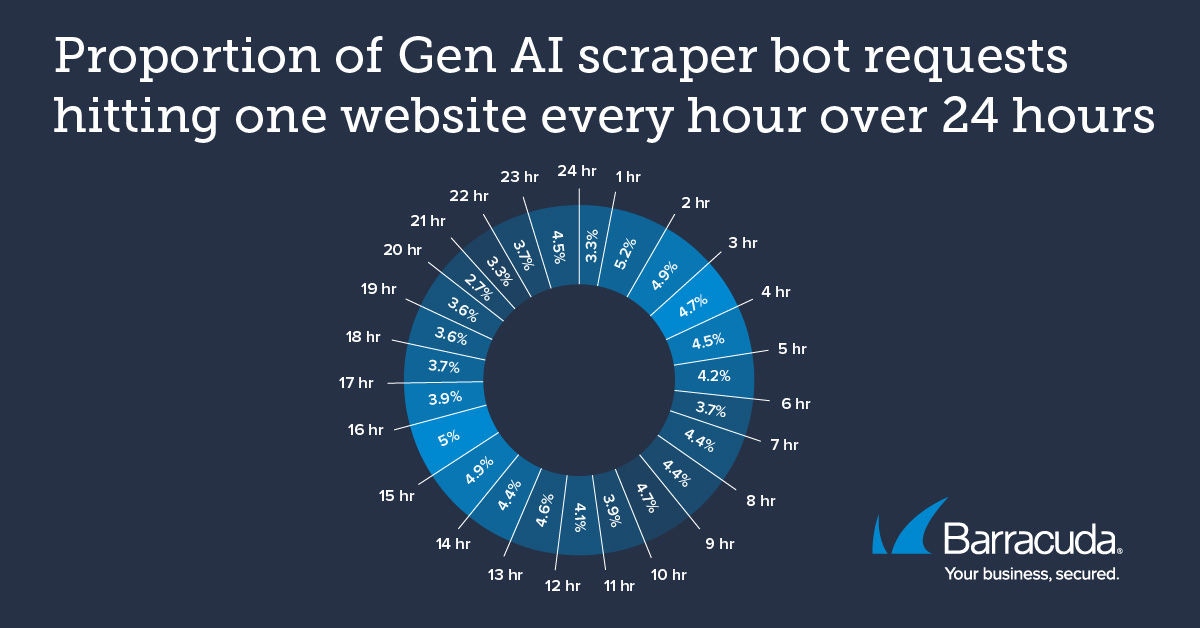

- El análisis del tráfico de bots grises dirigido a una aplicación web rastreada encontró que las solicitudes se mantuvieron relativamente constantes durante 24 horas, con un promedio de alrededor de 17,000 solicitudes por hora.

Esta coherencia del tráfico de solicitudes era inesperada. Generalmente se asume, y a menudo es el caso, que el tráfico de bots grises llega en oleadas, golpeando un sitio web durante unos minutos a una hora más o menos antes de volver a caer. Ambos escenarios, bombardeo constante o aumentos inesperados de tráfico ad hoc, presentan desafíos para la aplicación web.

Impacto en el negocio

Los bots grises pueden ser agresivos a la hora de recopilar datos y pueden eliminar información sin permiso. La actividad de los bots grises puede abrumar el tráfico web de la aplicación, interrumpir las operaciones y recopilar grandes volúmenes de datos creativos o comerciales patentados.

El raspado y el uso posterior de datos protegidos por derechos de autor por parte de los modelos de entrenamiento de IA pueden violar los derechos legales de los propietarios.

El raspado frecuente por bots aumenta la carga del servidor, lo que puede degradar el rendimiento de la aplicación web y afectar la experiencia del usuario.

También pueden aumentar los costos de alojamiento de aplicaciones debido al aumento en el uso de CPU en la nube y el consumo de ancho de banda.

Además, la presencia de bots raspadores de IA puede distorsionar el análisis del sitio web, lo que dificulta que las organizaciones rastreen el comportamiento genuino y tomen decisiones comerciales informadas. Muchas aplicaciones web se basan en el seguimiento del comportamiento del usuario y en flujos de trabajo populares para tomar decisiones basadas en datos. Los bots de IA generativa pueden distorsionar estas métricas, lo que da lugar a información engañosa y a una mala toma de decisiones.

También existen riesgos para la privacidad de los datos. Algunas industrias, como la atención médica y las finanzas, pueden enfrentar problemas de cumplimiento normativo si se extraen sus datos de propiedad o de clientes.

Por último, pero no menos importante, los usuarios y clientes pueden perder la confianza en una plataforma si el contenido generado por IA la inunda o si sus datos se utilizan sin consentimiento.

Tonos de gris

Los bots grises de la Generación IA más prolíficos detectados a principios de 2025 incluyen ClaudeBot y los bots de TikTok (Bytespider).

ClaudeBot

ClaudeBot es el bot gris de la Generación IA más activo de nuestro conjunto de datos por un margen considerable. ClaudeBot recopila datos para entrenar a Claude, una herramienta de IA generativa destinada al uso diario generalizado.

Es probable que las incesantes solicitudes de ClaudeBot afecten a muchas de sus aplicaciones web específicas. Anthropic, la compañía detrás de Claude, presenta contenido en su sitio web que explica cómo se comporta ClaudeBot y cómo bloquear la actividad de los raspadores.

Este tipo de contenido también aparece en los sitios web de algunos de los otros bots grises detectados por los sistemas de detección de BARRACUDA, incluidos OpenAI/GPTbot y Google-Extended.

TikTok

TikTok es un servicio de alojamiento de videos de formato corto con poco más de dos mil millones de usuarios en todo el mundo. Es propiedad de la empresa china de Internet ByteDance, que utiliza un bot raspador de IA llamado Bytespider para entrenar modelos generativos de IA. Los datos proporcionan a TikTok información sobre las últimas preferencias y tendencias de los usuarios, lo que ayuda a mejorar el motor de recomendación de contenidos de TikTok y otras funciones impulsadas por la IA, como las búsquedas de palabras clave para publicidad. Bytespider ha sido reportado como particularmente agresivo y sin escrúpulos.

Otros dos bots de raspado generativo de IA detectados por los sistemas BARRACUDA a finales de 2024/principios de 2025 fueron PerplexityBot y DeepSeekBot.

Mantener alejados a los bots grises

Los datos sugieren que las bots grises, como la bots de la Generación IA, son ahora un componente cotidiano del tráfico de bots en línea y han llegado para quedarse. Es hora de que las organizaciones los tengan en cuenta en las estrategias de seguridad.

Existen directrices para los sitios web y las empresas que están detrás de los bots de IA generativa. Por ejemplo, los sitios web pueden implementar robots.txt. Esta es una línea de código agregada al sitio web que le indica a un raspador que no debe tomar ninguno de los datos de ese sitio.

Robots.txt no es jurídicamente vinculante. Además, para que robots.txt sea efectiva, es necesario agregar el nombre específico de los robots raspadores. Esto allana el camino para que los bots grises menos escrupulosos ignoren la configuración de robots.txt o mantengan confidencial el nombre específico de su raspador o lo cambien regularmente.

Para asegurarse de que su aplicación web esté protegida contra el impacto de la botsgris, considere implementar una protección contra bots capaz de detectar y bloquear la actividad generativa de los bots de raspado de IA.

Por ejemplo, BARRACUDA Advanced bots Protection aprovecha las tecnologías de IA y aprendizaje automático de vanguardia para abordar la amenaza única que representan las botsgrises, con detección basada en el comportamiento, aprendizaje automático adaptativo, huellas dactilares integrales y bloqueo en tiempo real.

Los bots de IA generativa no son solo una tendencia pasajera, sino que, como muestran nuestros datos, ahora son convencionales y persistentes. Los debates éticos, legales y comerciales en torno a los bots grises parecen que continuarán durante algún tiempo. Mientras tanto, con las herramientas de seguridad adecuadas, tiene la tranquilidad de saber que sus datos siguen siendo suyos.

Informe sobre brechas de seguridad del correo electrónico 2025

Principales hallazgos sobre la experiencia y el impacto de las brechas de seguridad del correo electrónico en organizaciones de todo el mundo

Suscríbase al blog de Barracuda.

Regístrese para recibir Threat Spotlight, comentarios de la industria y más.

Informe sobre perspectivas de clientes MSP 2025

Una perspectiva global sobre lo que las organizaciones necesitan y desean de sus proveedores de servicios gestionados de ciberseguridad.